Descubriendo el protocolo de contexto de modelo (MCP)

Tiempo estimado de lectura: 8 minutos

Puntos clave

- MCP es un protocolo abierto para integrar modelos de lenguaje y agentes de IA con herramientas, datos y servicios externos.

- Su estandarización permite simplificar la integración de IA en empresas y apps, resolviendo el problema de múltiples conectores personalizados («problema NxM»).

- MCP se basa en un modelo de cliente-servidor inspirado en el Language Server Protocol.

- Gran adopción: apoyado por OpenAI, Google DeepMind, Anthropic y un ecosistema de desarrolladores en expansión.

- Paso clave para normalizar la interoperabilidad y la seguridad de los agentes de IA en organizaciones modernas.

Tabla de contenidos

Objetivo y Características Clave

El protocolo de contexto de modelo (MCP) surge como respuesta a la necesidad de conectar de forma estandarizada los modelos de IA—especialmente LLMs—con sistemas, fuentes de datos y servicios externos (ver explicación técnica).

¿Por qué es importante? El MCP busca reducir la fragmentación, romper silos y permitir que un modelo acceda de forma segura y uniforme a distintas herramientas, datos, archivos o APIs externas, más allá de sus datos preentrenados (source).

- Capa de estandarización: El MCP actúa como una interfaz universal para acceder a repositorios, bases de datos, plataformas (Slack, Notion, etc.) y servicios empresariales.

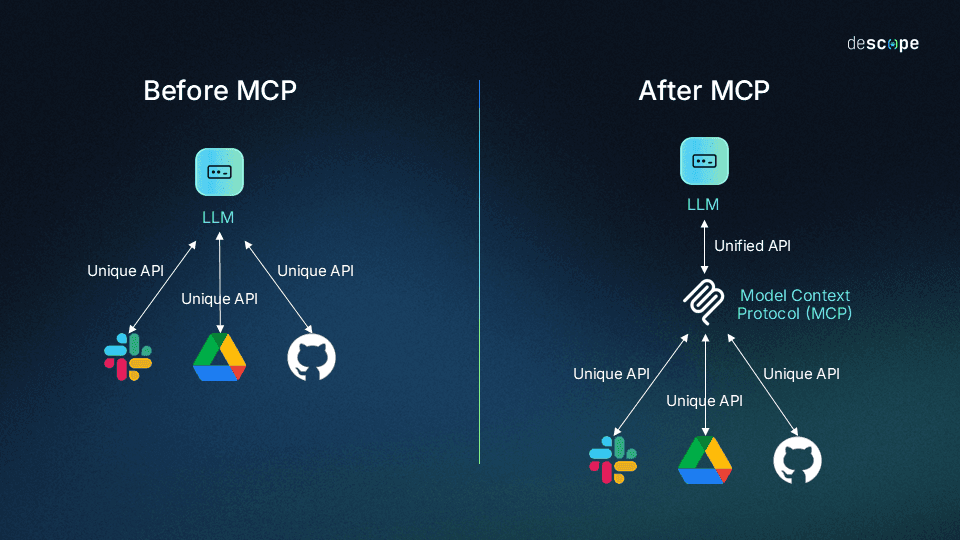

- Solución al «problema NxM»: Antes, cada nueva integración requería conectar manualmente cada herramienta a cada modelo. MCP introduce un estándar común para evitar esta maraña de integraciones (IBM).

- Soporte de agentes de IA: Ahora los agentes pueden buscar, modificar y desencadenar acciones fuera de su entrenamiento, superando límites tradicionales.

Arquitectura y Componentes Principales

La arquitectura MCP se basa en un modelo cliente-servidor, tomando inspiración del Language Server Protocol (LSP) (fuente técnica).

Los componentes clave incluyen:

- Application Host: Donde reside el LLM o agente (ej: Claude Desktop, AI IDE) (más sobre hosts).

- Cliente MCP: Incorporado en el host de la aplicación, actúa como intermediario de comunicación con servidores MCP externos (Anthropic).

- Servidor MCP: Expone funciones, contexto, acceso a archivos, consultas a BBDD o activación de APIs (Claude Docs).

- Capa de transporte: Utiliza JSON-RPC 2.0; canales como stdio para entornos locales y HTTP/SSE para conexiones remotas (fuente).

El acceso es seguro y autenticado; se desarrollan mejoras para permisos granulares y control de alcance (avance en seguridad).

Cómo funciona MCP (Ejemplo de Casos de Uso)

Imagina que un LLM en una herramienta de productividad debe interactuar con calendarios, CRM o consultar bases de datos. Con MCP, ya no se necesitan plug-ins específicos. La aplicación actúa como cliente MCP y realiza un apretón de manos estandarizado con el servidor MCP, que da acceso seguro a las fuentes requeridas (fuente ejemplo).

- Sector empresarial: Empresas como Block y Apollo han usado MCP para conectar sistemas internos y agentes IA (Anthropic anuncio).

- Herramientas para desarrolladores: IDEs como Zed, Replit, Codeium y Sourcegraph utilizan MCP para búsqueda de código y asistencia contextual (Neo4j).

- Proveedores de IA: OpenAI, Google DeepMind y Claude ya lo han adoptado (documentación OpenAI | sitio oficial MCP).

La especificación es abierta y viva, existen servidores de referencia y documentación en continuo crecimiento.

Comparación con los enfoques anteriores

Antes, cada integración de IA dependía de APIs o plug-ins propietarios. Esto implicaba múltiples desarrollos redundantes y complicaba la portabilidad y la seguridad.

MCP ofrece ahora un protocolo único, abierto e independiente del proveedor. Normaliza la integración de IA — como el USB-C en hardware — reduciendo la complejidad y mejorando la seguridad y control de acceso.

Desarrollos en curso

El MCP vive una rápida evolución: se actualizan las especificaciones, crecen los servidores de referencia y hay trabajo conjunto entre proveedores como Anthropic, Cloudflare y OpenAI para normalizar y ampliar el protocolo.

Resumen

En síntesis, el MCP se posiciona como el estándar universal para conectar modelos de inteligencia artificial con datos, herramientas y servicios empresariales del mundo real.

Su naturaleza abierta, interoperable y orientada a despliegues seguros y escalables lo está transformando en la infraestructura fundamental para la siguiente generación de agentes y aplicaciones de IA (Claudes Docs | IBM).

Preguntas frecuentes

-

¿Quién puede implementar el protocolo MCP?

MCP es abierto y puede ser implementado tanto por empresas como por desarrolladores individuales. Existen servidores, SDKs y documentación pública para facilitar su adopción.

-

¿Qué beneficios concretos ofrece frente a las integraciones tradicionales?

Reduce la redundancia (problema NxM), mejora la seguridad, la interoperabilidad y permite a las IA interactuar sin depender de soluciones propietarias y poco portables.

-

¿Dónde puedo ver implementaciones reales o ejemplos?

Puedes consultar la página oficial de Anthropic y la documentación de Claude para casos de uso y guías.

-

¿Es MCP seguro para datos sensibles?

Sí. MCP encripta el transporte, soporta autenticación, permisos y restricciones de alcance ajustables según políticas empresariales (seguridad y scopes).